在当今追求健康与品质的时代,电子烟作为传统香烟的理想替代品,正以其独特的魅力迅速占领市场。随着消费需求的不断升级,用户对电子烟的功能和体验提出了更高的要求。今天,让我们一同探索电子烟领域中LCD、LED、触摸以及LDO技术带来的卓越变革。LJQ5661

LCD与LED显示,开启可视化新纪元

实时信息精准呈现

传统电子烟往往无法直观地让用户了解设备状态。而如今,LCD和LED显示技术的应用,为电子烟带来了质的飞跃。通过LCD显示屏,用户可以清晰地看到电子烟的剩余电量、剩余油量等关键信息,告别盲目使用的困扰。LED显示则以其独特的灯光效果,为电子烟增添了时尚与科技感,不同颜色的灯光闪烁,可表示不同的工作状态,让使用体验更加直观有趣

永嘉微电芯片助力,小体积大作为

永嘉微电(VINKA)为电子烟的显示功能提供了强大的支持。其各种显示驱动芯片,拥有多种QFN/DFN/SOT23-6L等小体积封装,完美契合电子烟产品PCB板小体积的特点。

电子烟PCBA通常包括以下几个主要组成部分:

控制芯片:负责控制电子烟的工作模式、功率输出等功能。

电源管理:负责电子烟电源供应和管理,包括电池充放电保护、电压稳定等功能。

传感器:用于检测用户的吸气动作,触发电子烟的工作。

LCD显示屏:用于显示电子烟的工作状态、电量等信息。

总成充电接口:用于连接充电器,给电子烟充电。

除了以上主要组成部分,电子烟PCBA还可能包括其他辅助元件,如LED指示灯、温度传感器等,以及与其他外部组件(如喷嘴、雾化器等)的连接接口

产品选型推荐:

对于显示功能方面,用LCD驱动来实现显示。实时的设备信息显示可以满足客户对产品的需求,如剩余电量显示、剩余油量显示及各种定制化LOGO的显示等等。

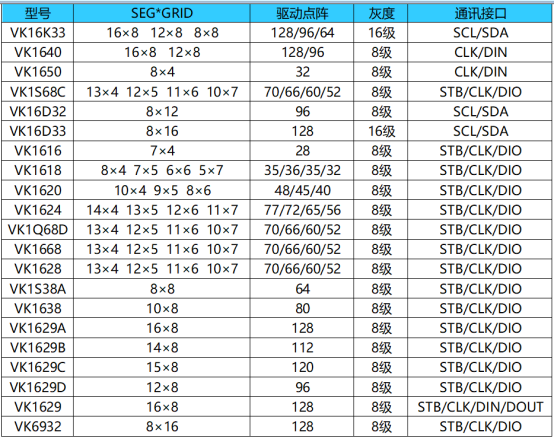

永嘉微电(VINKA)可提供各种显示驱动芯片,

多种 QFN/DFN/SSOP/TSSOP 等小体积封装供选择,满足电子烟产品 PCB 板小体积的特点。

推荐 LED 数码管显示驱动如下: