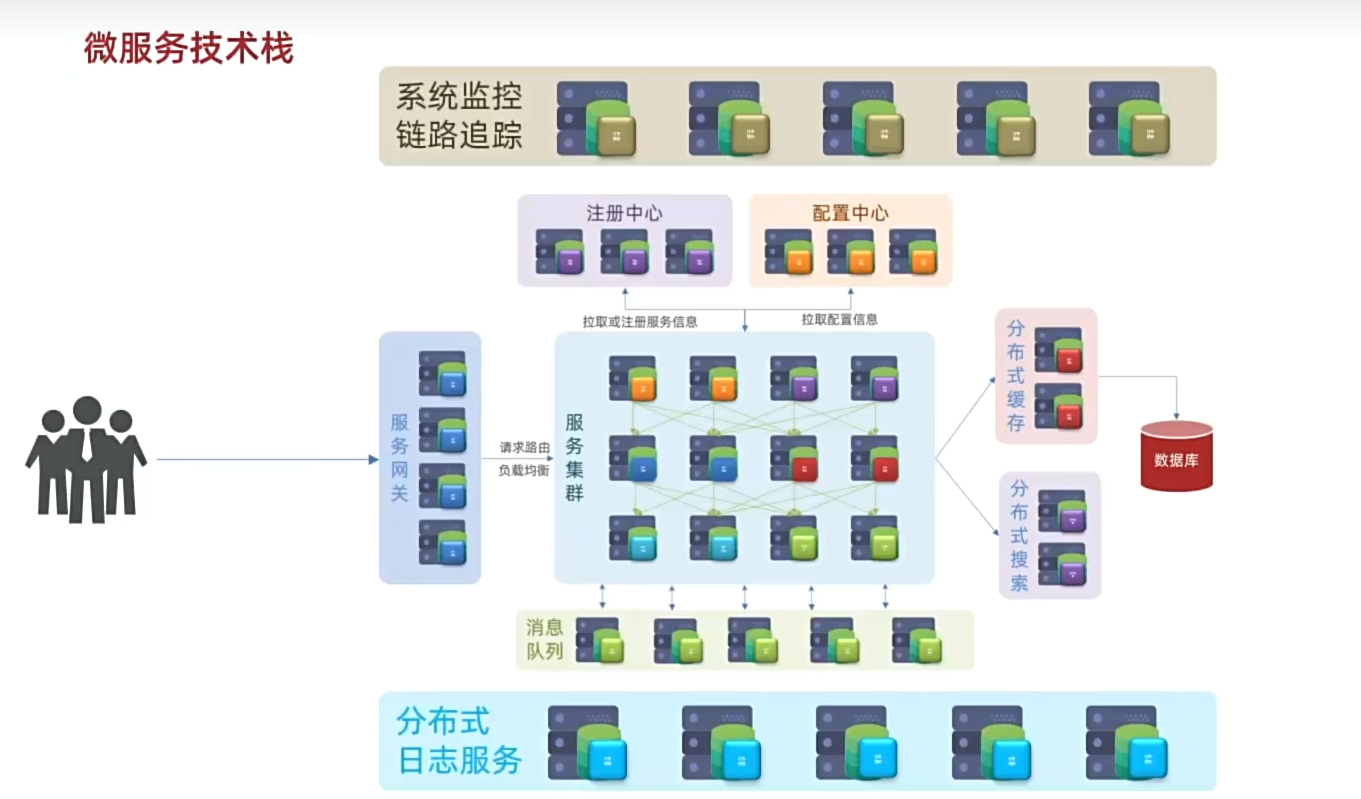

微服务学习-01-微服务技术栈导学

一、注册中心

作用:记录每一个服务的IP 端口 和能干什么事情等信息...

二、配置中心

作用:统一管理服务群中所有服务的配置文件,在配置中心修改完配置文件后 会通知相关的服务,实现配置文件的热更新

三、服务网关

作用:请求路由 负载均衡

四、分布式缓存:

用户查询会先到缓存,缓存未命中 再去查询数据库

五、消息队列

异步通信,提高服务的并发

六、分布式日志服务

作用:统计分析整个集群中的所有服务运行状态

七、系统监控/链路追踪

作用:实时监控集群当中每一个服务节点的运行状态 CPU负载 内存的占等等...

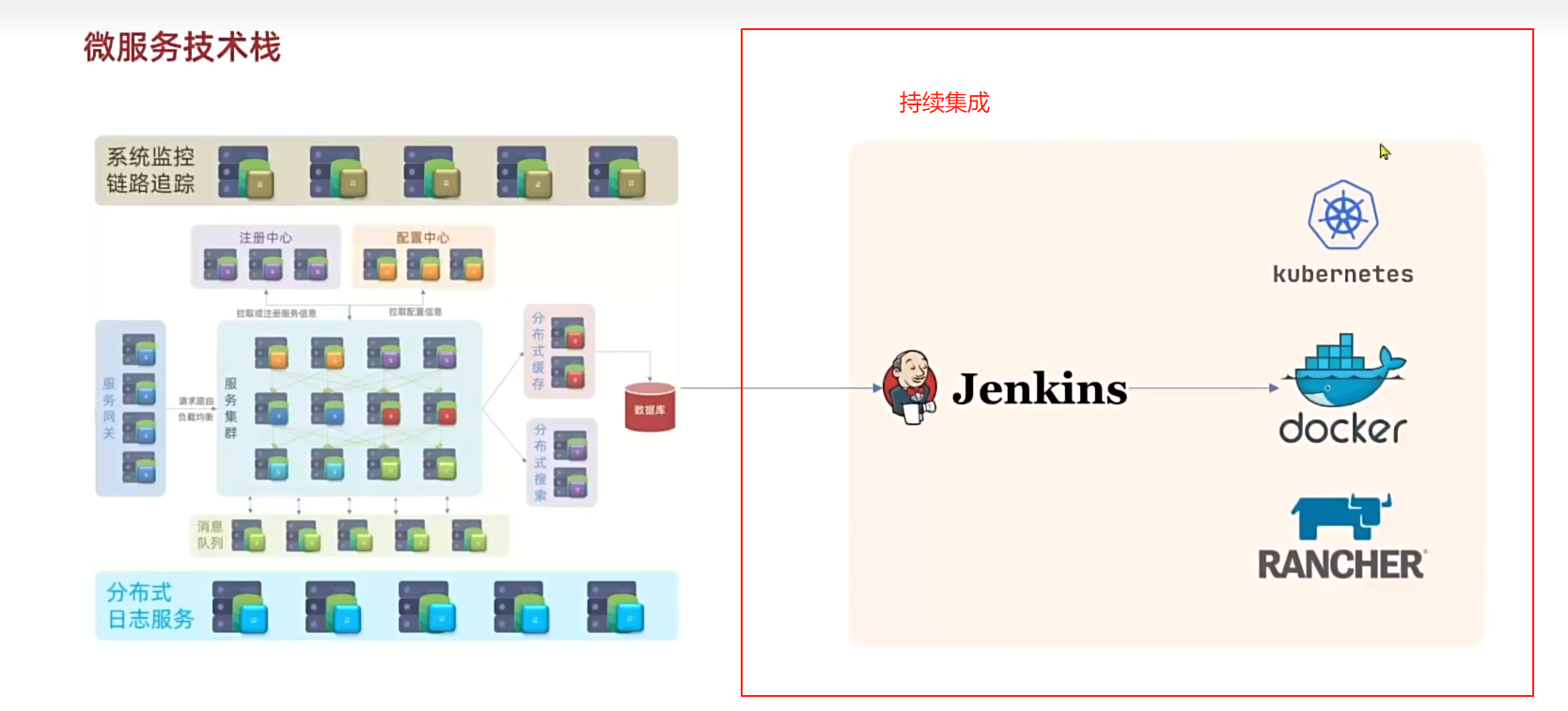

八、Jenkins/Docker/K8s

作用:微服务部署/持续集成