论文信息

论文标题:AlpaGasus: Training A Better Alpaca with Fewer Data

论文作者:陈立畅、李诗阳、闫军、王浩、卡尔帕·古纳拉特纳、维卡斯·亚达夫、唐政、维贾伊·斯里尼瓦桑、周天翊、黄恒、金红霞

论文来源:ICLR 2024

论文地址:link

论文代码:link

Abstract

-

问题背景:大语言模型(LLMs)通过在有监督的指令 / 回复数据上进行指令微调(IFT)增强指令跟随能力,但常用的 IFT 数据集(如 Alpaca 的 52k 数据)存在大量低质量实例,其回复有误或不相关,对 IFT 具有误导性和危害性。

-

提出的策略:提出一种简单有效的数据选择策略,即利用强大的大语言模型(如 ChatGPT)自动识别并过滤低质量数据。

-

AlpaGasus 的构建与表现:

- 构建了 AlpaGasus,它仅在从 Alpaca 的 52k 数据中筛选出的 9k 高质量数据上进行微调。

- 在多个测试集上,经 GPT - 4 评估和可控人工评估,AlpaGasus 的表现显著优于原始 Alpaca。

- 其 130 亿参数版本在测试任务上的性能达到教师大语言模型(生成 52k 数据的 Text - Davinci - 003)的 90% 以上。

-

优势与有效性:

- 训练速度提升 5.7 倍,70 亿参数版本的训练时间从 Alpaca 的 80 分钟减少到 14 分钟。

- 实验证明该方法在各种数据集、基础模型和大语言模型过滤器上均有效。

-

意义:AlpaGasus 展示了一种以数据为中心的新型 IFT 范式,可普遍应用于指令调优数据,实现更快训练和更优的指令跟随模型。

1 INTRODUCTION

- 指令微调(IFT)是预训练大型语言模型(LLMs)获得指令遵循能力的关键持续训练阶段,旨在使模型行为与多样化人类指令及响应对齐。

- 开源指令微调模型系列显示,更优的 IFT 数据对齐能提升模型指令遵循能力,例如基于同一基础模型的 GPT-4-LLM 因数据质量更优,表现优于 ALPACA,凸显数据质量的重要性。

- Alpaca-cleaned 是首个过滤 ALPACA 数据集中不良数据的尝试,但需人工参与,而自动过滤 IFT 数据中低质量数据的方法尚未得到研究。

- 本文提出一种高效、自动且准确的指令微调(IFT)数据过滤策略:利用强大型语言模型(如 ChatGPT)通过特定提示词评估每个(指令、输入、响应)三元组质量,过滤掉低于阈值的样本。

- 将该过滤器应用于训练 ALPACA 的 52k 数据,发现多数数据存在质量问题;用过滤后的 9k 子集训练出的 ALPAGASUS,性能优于原 ALPACA,且训练时间从 80 分钟缩短至 14 分钟(4×NVIDIA A100 GPU)。

- 验证表明该方法在多种数据集(如 Dolly、Alpaca)、基础模型(如 LLaMA - 1/2)和 LLM 过滤器(如 ChatGPT、Claude - 2)上均有效,说明 IFT 中数据质量可超越数量,为 LLM 微调提供更高效范式。

- 对 ALPAGASUS 的评估涵盖自由形式指令评估、多种基准测试和人类研究,选用四个人类指令测试集(来自 WizardLM、Vicuna 等),主要以 GPT-4 为评估工具。

- 在 7B 和 13B 模型对比中,ALPAGASUS 在所有四个测试集上表现显著优于 ALPACA;人类研究和基准测试也证实其优越性,且在 Vicuna 测试集的多数细分任务(通用、角色扮演等)中占优。

- 该数据过滤方法具有可扩展性和自动化优势,表明合理管控训练数据质量能显著提升 IFT 性能并节省计算资源,相关策略可推广至其他指令微调数据集和 LLM,为实用化部署提供新方向。

2 METHODOLOGY

训练流水线:

-

数据筛选阶段

- 筛选工具:使用强语言模型(如 ChatGPT、Claude-2)作为自动评分器,基于 “准确性” 等维度对数据质量评分(0-5 分)。

- 筛选标准:从 ALPACA 的 52k 数据中,选取评分≥4.5 分的样本,最终得到 9k 高质量数据(占原数据 17.75%)。

- 优势:避免人工筛选的高成本和主观性,自动过滤错误、无关的低质量样本。

-

模型微调阶段

- 基础模型:采用 LLaMA 系列模型(7B、13B 参数),后续扩展到 LLaMA-2 验证通用性。

- 训练配置:沿用 ALPACA 的训练脚本和超参数(如批次大小 128、学习率 2e-5(7B)/1e-5(13B)),仅调整训练数据量。

- 训练效率:7B 模型训练时间从 80 分钟缩短至 14 分钟(4×NVIDIA A100 GPU),13B 模型从 5.5 小时缩短至 1 小时,训练速度提升 5.7 倍。

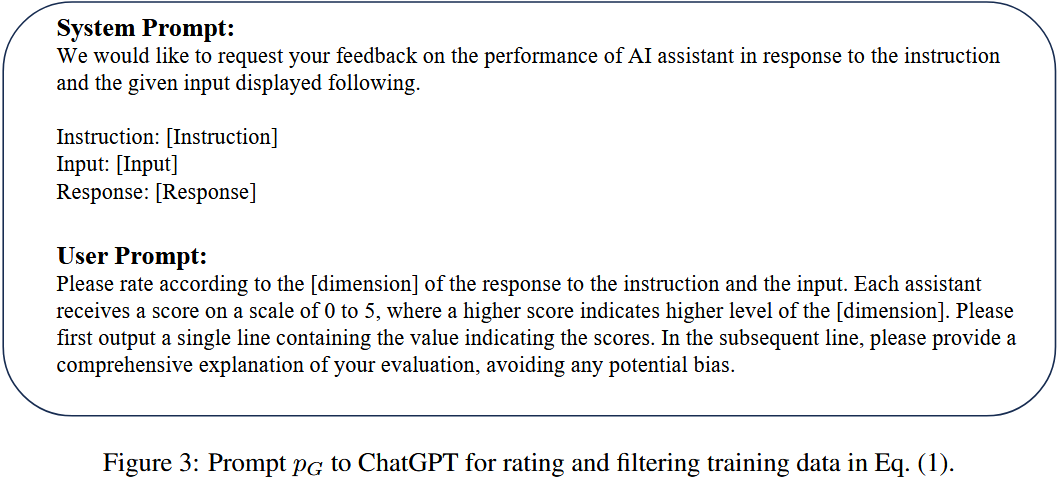

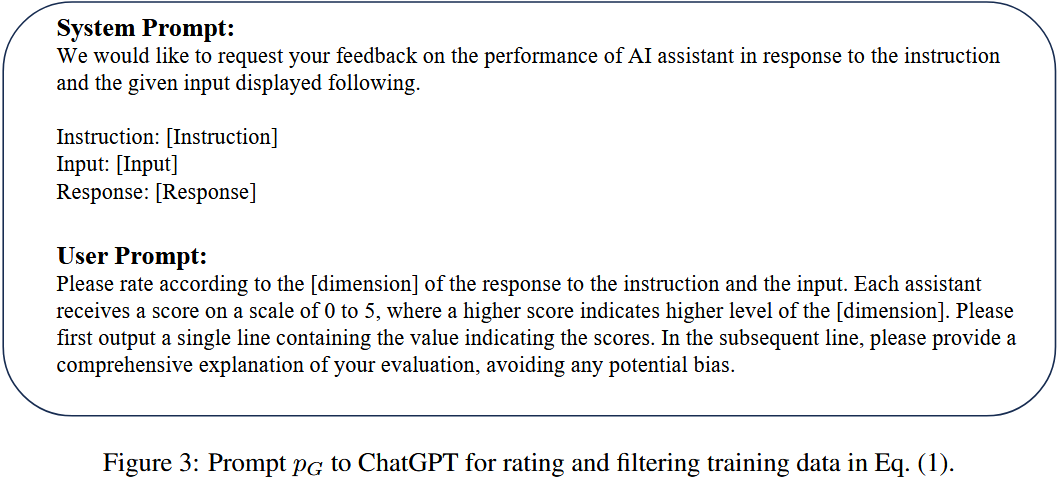

评估指令模板:

系统提示:我们想请求您对 AI 助手的性能提供反馈,以响应下面显示的指令和给定输入。指令:[指令]输入:[输入]响应:[响应]用户提示:请根据对指令和输入的响应的[维度]进行评分。每个助手都会收到一个 0 到 5 的分数,其中分数越高表示 [维度] 级别越高。请先输出一行,其中包含指示分数的值。在接下来的行中,请对您的评估进行全面解释,避免任何潜在的偏见。

ALPAGASUS 得分统计:

3 EXPERIMENT

评估 LLMs 的指令遵循能力存在两大难点:

- 同一指令可能存在多个合理响应(

multiple eligible responses),难以用单一标准判定优劣;

- 人类评估结果难以复现(受主观偏差影响),且效率低、可扩展性差。

鉴于近年自动化评估技术的进步,其在可扩展性(批量处理样本)和可解释性(评估逻辑可追溯)上优于人类评估,因此采用API 大语言模型作为 “裁判”(记为 $J(⋅)$,如 GPT-4),对比两个模型( $\theta_S$ 和 $\theta_S$)的性能。

- 对比对象:从测试集 $D$ 中抽取指令 $z$,获取两个模型的响应 —— $F(z; \theta_V)$(基于原始数据训练的模型响应)和 $F(z; \theta_S)$(基于筛选后数据训练的模型响应)。

- 评分方式:裁判模型 $J(⋅)$ 对两个响应分别打分(1-10 分),目标是θS的得分更高,即对大多数指令 $z$ 满足 $J(F(z; \theta_S)) \geq J(F(z; \theta_V))$。

- 裁判提示细节:将两个模型的响应输入给裁判(如 GPT-4),并通过特定提示词要求其基于 “有用性、相关性、准确性、详细程度” 等维度评分。

- 位置偏差缓解:LLM 裁判可能存在 “位置偏好”(如倾向于偏好先出现的响应),因此通过两种顺序呈现响应(AlpaGasus 在前 / 在后),并基于两次结果综合判定:

- Win(胜):AlpaGasus 两次均胜,或一胜一平;

- Tie(平):AlpaGasus 两次均平,或一胜一负;

- Lose(负):AlpaGasus 两次均负,或一负一平。

- 控制变量:

- 允许模型生成最多 1024 个 token,避免响应被截断;

- 对 ChatGPT、Claude、Text-Davinci-003 等模型,将温度参数(temperature)设为 0.0,减少随机性,保证公平性。

质量比数量更重要

- 对比对象:AlpaGasus-9k 与 Alpaca-52k,二者仅训练数据不同,AlpaGasus-9k 从 Alpaca-52k 的 52k 数据中筛选出 9k 数据,超参数和训练脚本一致。

- 评估结果:AlpaGasus-9k 在所有四个测试集上显著优于 Alpaca-52k;以 LLaMA-2 为基础模型时,结果一致。

- 结论:数据筛选方法具有普适性,不受模型选择影响;仅用原始数据集 17.75% 的筛选数据,就能通过该训练数据选择方法获得更优性能。

- 对比对象:ALPAGASUS(采用质量引导筛选数据)与 ALPACA-9k-random(采用随机筛选的 Alpaca 52k 数据子集),二者初始模型相同(LLaMA)、训练样本量相同(9k),仅数据选择标准不同。

- 评估结果:在 7B 和 13B 两种模型规模下,ALPAGASUS-9k 均显著优于 ALPACA-9k-random。

- 结论:验证了所选数据的高质量及其对指令微调(IFT)性能的重要性,表明质量引导筛选策略有效。

数据筛选阈值 τ 的影响

- 主实验设 τ=4.5,从 52k 数据中筛选 9k 训练 AlpaGasus;当 τ=4.0(筛选 39k 数据)时,ALPACA-39k 在部分测试集优于 ALPACA-52k,部分则无优势,但仍不及用更少高质量数据训练的 AlpaGasus,表明低质量数据对 IFT 有负面影响。

- 实验:从 AlpaGasus 的 9k 筛选数据中随机抽取 3k、6k 数据,用相同脚本微调 LLaMA 得到其变体。

- 结果:图 8 显示,9k 数据训练的 AlpaGasus 在所有四个测试集上表现最佳。

- 结论:更多高质量数据对指令微调(IFT)有积极影响,能提升模型性能。

基准性能

- 评估基准:遵循 InstructEval,在 MMLU、DROP、Humaneval、BBH 四个基准数据集上评估模型性能。

- 结果:表 2 显示,ALPAGASUS-7B、13B 在 3/4 数据集上表现更优,且用筛选数据训练的模型在所有基准上均优于随机选择数据训练的模型。

- 结论:验证了筛选算法的有效性。

- 适用范围:除机器生成数据集外,该筛选方法也适用于人类编写数据集。

- 实验对象:以包含 1.5 万条高质量人类生成 prompt/response 对的 Databricks-dolly-15k 数据集为研究对象,其涵盖多种人类认知活动。

- 筛选与训练:设阈值 τ=4.5,筛选出 2996 个样本;用该 3k 筛选数据训练 7B/13B LLaMA 模型。

- 结果:训练模型性能优于用全部 1.5k 数据训练的模型(见图 10、21),证明该筛选方法对人类编写数据集有效。

- 补充:得分分布见附录 B,训练超参数详情见附录 D.8。