Rivers are important in culture

河流在文化中具有重要意义

Rivers have played an important role in shaping culture throughout history, They have served as a source of life for civilizations, providing water for drinking and transportation.

纵观历史,河流在塑造文化方面发挥着重要作用。它们为文明提供生命之源,供给饮用水和交通运输之便。

Many ancient civilizations, such as the Egyptians developed along the banks of rivers like the Nile, using their resources.

许多古代文明,如埃及文明,正是依托尼罗河等河流沿岸发展起来,充分利用了河流资源。

Moreover. rivers have often been the centre of business, improving the exchange of goods and ideas between different areas.

此外,河流往往成为商业中心,促进了不同地区间商品与思想的交流。

They have acted as natural highways, allowing people to travel easily and influenced the way people live and connect with each other.

它们作为天然高速公路,便利了人们的出行,影响着人们的生活方式和彼此联系。

Rivers have meanwhile become cultural symbols (象f) in various societies around the world. For example, the Mississippi River is often linked with American history and culture, symbolizing the spirit of exploration, adventure and freedom.

与此同时,河流已成为全球各地社会的文化象征。例如密西西比河常与美国历史文化相关联,象征着探索、冒险与自由精神。

Rivers have also been used as landmarks and symbols of specific areas or countries. They are commonly seen in literature and visual arts.

河流还被用作特定地区或国家的地标象征,常见于文学与视觉艺术作品中。

The cultural symbolism of rivers shows the deep emotional and psychological connection that people been inspired by the beauty and power of rivers, From classical pieces like Johann Strauss Ⅱ's The Blue Danube to popular songs like Creedence Clearwater Revival's Proud Mary, rivers have been a shared theme in music.

河流的文化象征意义展现了人们与河流深厚的情感与心理联系。从约翰·施特劳斯二世的《蓝色多瑙河》等古典乐章,到清水复兴合唱团的《骄傲的玛丽》等流行歌曲,河流始终是音乐创作的共同主题。

Similarly, rivers have been used to strengthen the visual storytelling and create a sense of atmosphere in films.

同样地,在电影中河流也被用于强化视觉叙事,营造氛围感。

Whether it's the river journey in Apocalypse Now or the poetic exploration of the river in The River by Jean Renoir, rivers have played a crucial role in shaping the cinematic experience.

无论是《现代启示录》中的河流之旅,还是让·雷诺阿《大河》中充满诗意的河流探索,河流都对塑造观影体验起着关键作用。

==

Rivers are important in culture

Rivers have played an important role in shaping culture throughout history, They have served as a source of life for civilizations, providing water for drinking and transportation.

Many ancient civilizations, such as the Egyptians developed along the banks of rivers like the Nile, using their resources.

Moreover. rivers have often been the centre of business, improving the exchange of goods and ideas between different areas.

They have acted as natural highways, allowing people to travel easily and influenced the way people live and connect with each other.

Rivers have meanwhile become cultural symbols (象f) in various societies around the world. For example, the Mississippi River is often linked with American history and culture, symbolizing the spirit of exploration, adventure and freedom.

Rivers have also been used as landmarks and symbols of specific areas or countries. They are commonly seen in literature and visual arts.

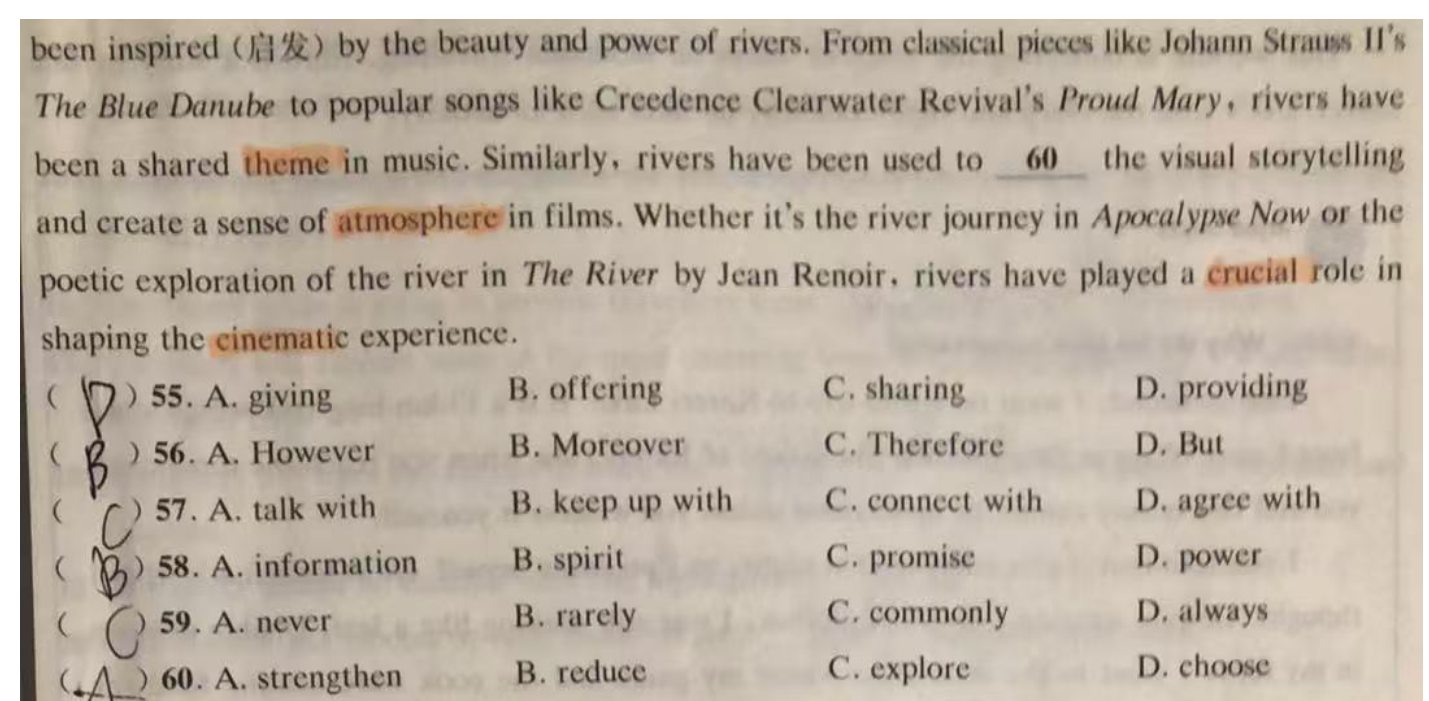

The cultural symbolism of rivers shows the deep emotional and psychological connection that people been inspired (启发) by the beauty and power of rivers, From classical pieces like Johann Strauss Ⅱ's The Blue Danube to popular songs like Creedence Clearwater Revival's Proud Mary, rivers have been a shared theme in music.

Similarly, rivers have been used to strengthen the visual storytelling and create a sense of atmosphere in films.

Whether it's the river journey in Apocalypse Now or the poetic exploration of the river in The River by Jean Renoir, rivers have played a crucial role in shaping the cinematic experience.